Am 25. April 2024 öffnet in Frankfurt am Main die Deutsche VMUG UserCon ihre Pforten. Es ist die erste UserCon in Deutschland seit der Übernahme von VMware durch Broadcom.

Die Deutsche VMUG UserCon ist das jährliche Treffen der sieben lokalen VMUG-Gruppen in Deutschland.

Keynote Speaker

Mit besonderer Freude können wir unsere diesjährigen Keynote Speaker präsentieren.

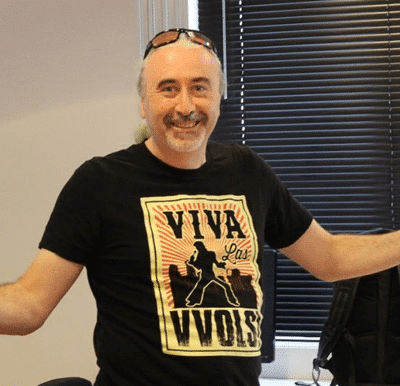

Mit Joe Baguley, CTO EMEA, der uns schon in mehreren zurückliegenden VMUG-Veranstaltungen unterstützte, hatten wir unseren Wunschkandidaten schon früh in der Planungsphase gewinnen können. Joe ist ein eloquenter und humorvoller Redner, der es versteht, sein Publikum auch bei komplexen Themen mitzunehmen.

Brad Tompkins, VMUG Executive Director dürfte regelmäßigen UserCon Besuchern bekannt sein. Er wird dieses Jahr nicht wie sonst per Videobotschaft zugeschaltet, sondern persönlich anwesend sein. Angesichts der vielen weltweit stattfindenen UserCons ist es ein besonderes Vergnügen, ihn in Frankfurt begrüßen zu dürfen.

Unser dritter Gast ist kein geringerer als der Broadcom Präsident und CEO Hock Tan. Seine Zusage nach Frankfurt zu kommen, ist erst seit Anfang März offiziell und hat auch die größten Optimisten im Organisationsteam überrascht. Die Geschichte dahinter begann beim letztjährigen VMUG Leader-Empfang während der VMware Explore in Barcelona. Der damalige noch-nicht VMware Chef kam als Überraschungsgast zum traditionellen VMUG Leader Empfang und plauderte mit den Leadern frei über seine Pläne mit VMware, VMware-Explore und der VMUG. Bei einem Glas Wein fragte ich ihn, ob er denn nicht 2024 nach Frankfurt zur UserCon kommen wolle. Er bejahte dies, wenn sein Kalender dies zuließe und wir sollen die Details mit seinem Büro klären. Wir werteten seine Antwort damals als ein höfliches ‘vielleicht’ ohne ernsthaft darauf zu hoffen. An dieser Stelle ein herzliches Dankeschön an das VMUG HQ in den Niederlanden, die diesen Termin möglich machten.

President and CEO,

Broadcom

CTO EMEA,

VMware by Broadcom

Executive Director,

VMUG

Breakout Sessions

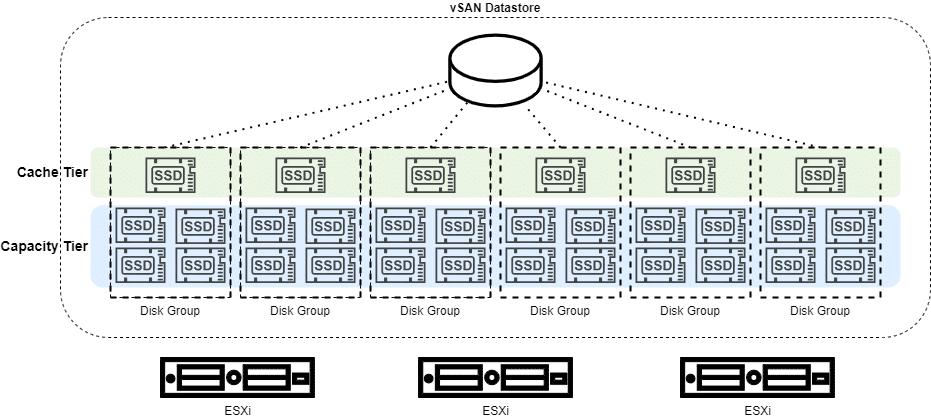

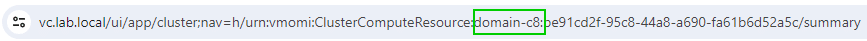

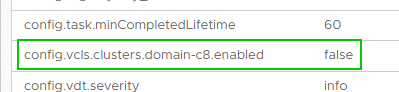

Aber was wäre eine UserCon ohne ihre Vorträge in den zahlreichen Breakout Sessions. In vier parallelen Vortragsreihen mit je 6 Blöcken werden technische Hintergründe beleuchtet und neue Techniken vorgestellt. Auch hier konnten wir hochkarätige Referenten gewinnen. Darunter auch die vRockstars Duncan Epping und Cormac Hogan, die uns neueste Entwicklungen zum Thema vSAN ESA bzw. DSM 2.0 näher bringen werden.

Chief Technologist Cloud Infrastructure

Chief Technologist VCF division

Agenda zur Deutschen VMUG UserCon 2024

Closing Keynote

Die Veranstaltung abrunden wird Björn Brundert (Broadcom). Auch er ein alter Bekannter bei Deutschen UserCons. 2022 sprach er die Keynote zur ersten UserCon nach der Pandemie. Unvergessen auch sein Vortrag zu Tanzu Kubernetes zur UserCon 2019, bei dem der Raum zu bersten drohte.

Registrierung und Eckdaten

Die Veranstaltung findet statt in Frankfurt am Main im Kap Europa (Osloer Str. 5, 60327 Frankfurt am Main). Die Teilnahme und Registrierung ist kostenlos.

Registrierung und Frühstück: 8:30 Uhr

Beginn: 9:30 Uhr