Im Fall eines Pfadverlustes wählt normalerweise das Path-Selection-Plugin (VMW_PSP_MRU) zufällig einen der verbleibenden Pfade als Alternative. Im VMware vSphere Blog erschien kürzlich ein Artikel, der die Methode der Pfad-Priorisierung unter vSphere5 beschreibt und den VMware KB-Artikel etwas erweitert ausführt. Im Blogartikel wird noch die alte Syntax (4.x) der vSphereCLI verwendet, diese funktioniert nicht mehr bei einem ESXi5.0.0. Aus diesem Grund habe ich unten die aktuelle Syntax angegeben, die auch im KB Artikel genannt wird.

Im Kern geht es darum, daß es drei Kategorien für Pfade gibt:

- ACTIVE

- ACTIVE_UO (active, unoptimized)

- STANDBY

Die Auswahlreihenfolge ist Active > Active_UO > Standby. Gleichwertige Pfade der selben Kategorie werden weiterhin von VMW_PSP_MRU zufällig ausgewählt. Die Defaulteinstellung der Priorität ist bei allen Pfaden “0” und unterscheidet sich damit nicht vom Verhalten früherer vSphere Versionen.

Wie setzt man die Priorität?

Mittels vSphereCLI können die Einstellungen ausgelesen und neu gesetzt werden. Eine Konfiguration über die GUI ist derzeit nicht möglich.

Achtung! Keine ESXCLI 4.0 Kommandos an einen ESXi 5.0.0 Server absenden!

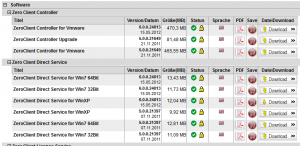

Die aktuelle Version gibt es bei VMware.

Im folgenden ist [connection] die Verbindungsdaten zum ESXi Server:

--server myserver.domain.com --user root --password mypassword

<vmhba pathname> könnte z.B. so aussehen: vmhba3:C0:T0:L0

# esxcli [connection] storage nmp psp generic pathconfig get -p <vmhba pathname> # esxcli [connection] storage nmp psp generic pathconfig set -p <vmhba pathname> -c rank=<rank Number>

Alternativ kann der Pfad auch über die NAA-ID (Network Addressing Authority identifier) bestimmt werden.

# esxcli [connection] storage nmp psp generic deviceconfig get --device=<naa.xxx>

Die so eingestellte Priorität des Pfades bleibt auch nach einem Neustart des Hosts erhalten.