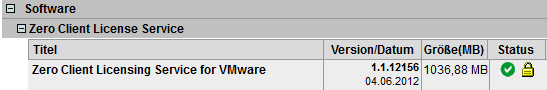

Nachdem erst kürzlich der Zeroclient-Lizenzserver (ZCLS) auf Version 1.1.12156 aktualisiert wurde, steht nun auch eine neue Version 6.0.1 des ZeroClient-Controllers (ex. Panomanager) in den Startlöchern. Ich konnte diese Version vorab testen und bin mit dem Ergebnis zufrieden. Sie wird sicher in Kürze auf der Fujitsu Downloadseite verfügbar sein.

- DirectService 6.0.1 lässt sich jetzt als Update installieren und bringt aktiviert den richtigen WDDM Treiber unter Windows 7. Das war unter Version 6.0.0 noch nicht ganz zufriedenstellend. Hier wurde der Pano-WDDM Treiber nur bei Neuinstallation von DirectService installiert.

Im folgenden Abschnitt wird der Upgradeprozess von ZCLS, ZCC und DirectService erklärt. „ZeroClient: Upgrade Lizenzserver und ZeroClient Controller“ weiterlesen