VMware vergibt jährlich die Auszeichnung vExpert an Personen, welche sich in besonderem Maße für die VMware Community eingesetzt haben. Dies kann entweder durch Veröffentlichungen, Vorträge, Blogs, oder durch Arbeit in der VMware User Group (VMUG) erfolgen. Es freut mich, 2023 zum siebten Mal in Folge Teil der vExpert Gemeinschaft zu sein.

Zusätzlich zum allgemeinen vExpert gibt es Unterprogramme für spezielle Anwendungszweige.

- Application Modernization

- AVI

- Cloud Management

- Cloud Provider

- End User Computing (EUC)

- Multi-Cloud

- NSX

- vExpertPro

- Security

Ich hatte mich für die drei Unterprogramme vExpertPro, Application Modernization und Multi-Cloud beworben und wurde in allen drei Kategorien angenommen.

vExpertPro

Die Aufgabe des vExpert PRO-Programms ist es, ein weltweites Netzwerk von vExperts zu schaffen, die bereit sind, neue vExperts in ihren lokalen Gemeinschaften zu finden, sie zu fördern und sie auf ihrem Weg zum vExpert als Mentoren zu begleiten.

Dafür gibt es vExpertPro in vielen Regionen der Welt. Ich selbst gehöre dieser Gruppe seit 2021 an und wurde für ein weiteres Jahr bestätigt.

vExpert Multi-Cloud

Der Bereich Multi-Cloud erstreckt sich über weite Teile des VMware Compute Portfolios. Der Begriff Cloud beinhaltet nicht nur die Public-Cloud, sondern auch lokale Datacenter (Private-Cloud) und Kombinationen aus beiden Ansätzen (Hybrid-Cloud). Darunter fallen zahlreiche Produkte wie vSphere, vSAN, VMware Cloud Foundation (VCF), Aria, VMware Cloud on AWS, Site Recovery Manager (SRM) oder vCloud Director (VCD).

Ich hatte mich 2023 erstmalig für diesen relativ neuen vExpert-Pfad beworben und wurde angenommen. Vielen Dank an die Business Unit für das Vertrauen.

vExpert Application Modernization

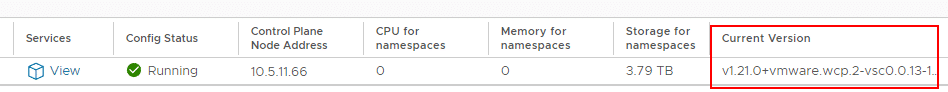

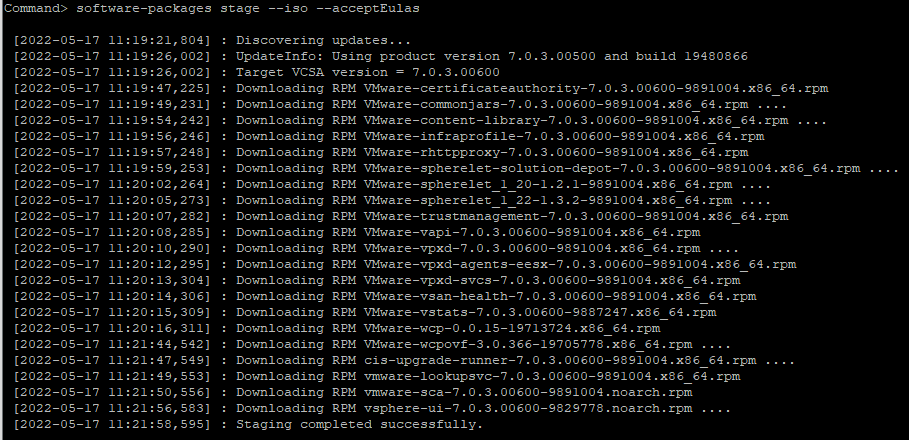

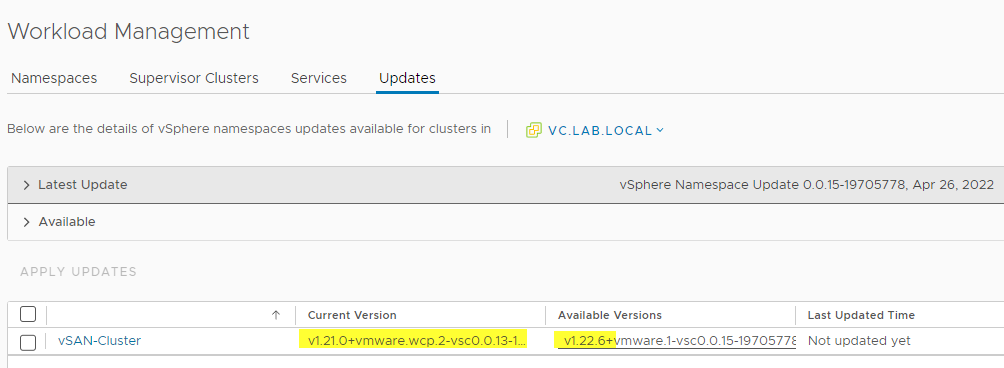

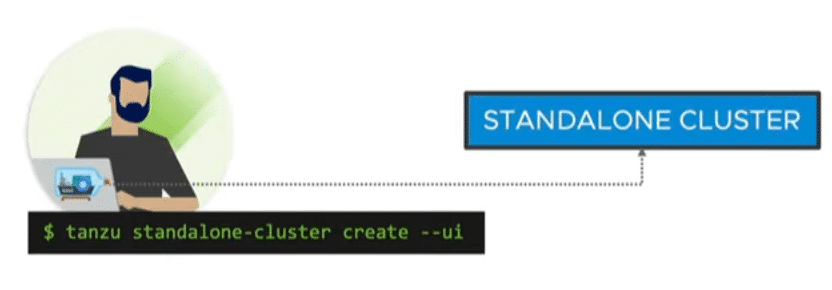

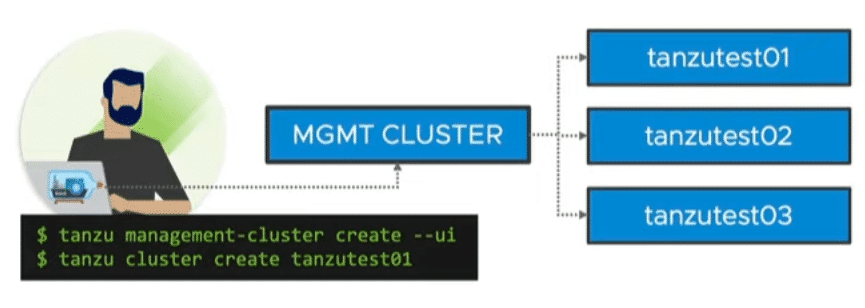

Application Modernization dreht sich um die Themenbereiche Tanzu und Kubernetes, sowie das Ökosystem rund um diese Anwendungen. Der Hintergrund wurde sehr ausführlich von Keith Lee beschrieben in seinem Artikel “Announcing the VMware Application Modernization vExpert Program 2023“.