Hier geht es zu Teil 1 – Planungsphase

Die Ware ist da

Letzten Dienstag freute ich mich richtig über eine Sendungsbenachrichtigung des Paketboten. Die Hardware ist unterwegs. Jetzt war es an der Zeit die Verkabelung klar zu machen. Ich mag keine Gordischen Knoten aus Patch- und Stromkabeln. Kabel werden beschriftet und mit Klettband gebündelt. Um es einfach zu halten, werde ich das vSAN Netz und Management LAN im ersten Schritt nicht redundant auslegen. Das sind aber immer noch 8 Patchkabel, die es zu verlegen gilt, plus vier Kabel für das iPMI Remotemanagement. Später fand ich heraus, dass das iPMI Interface einen Fallback auf den LAN Port macht, wenn am dedizierten Remotemanagement Port kein Kabel angeschlossen ist. Sehr erfreulich, denn es erspart vier Kabel und Switchports.

Host Hardware

Alle vier Hosts kamen fertig bestückt und hatten zu diesem Zeitpunkt bereits einen Burn-in Test bestanden. Die Servergehäuse sind kompakt und haben ungefähr die Abmessungen einer kleinen Pizzabox. 25,5 cm breit, 4,5 cm hoch und 22,5 cm tief. Aber vor dem Drücken des Startknopfes muss ich eine Blick unter die Haube werfen. 🙂

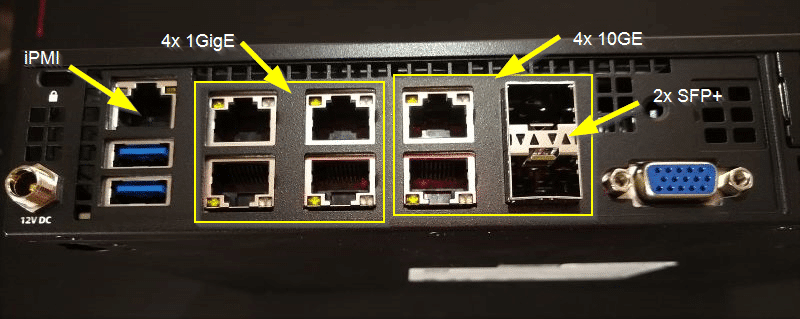

Beginnen wir mit der Rückseite. Wie man im Bild unten erkennen kann, ist der Server gut mit Anschlüssen ausgestattet. In der unteren linken Ecke ist der 12V Stomanschluss. Das Kabel kann mit einer Überwurfmutter fixiert werden. Dann folgen zwei USB 3.0 Anschlüsse und der iPMI Anschluss darüber. Das iPMI kommt ab Werk mit Videoumleitung (HTML5 oder Java). Dafür ist keine gesonderte Lizenz nötig.

In der Mitte sehen wir 4×1 Gbit (i350) LAN Anschlüsse und vier 10 Gbit (X722) Anschlüsse. Davon sind zwei als SFP+ ausgelegt. In der unteren rechten Ecke ist der VGA Anschluss, der aber Dank Video-Umleitung nicht gebraucht wird. Dennoch ist es gut, einen für Notfälle zur Verfügung zu haben.

Innenleben

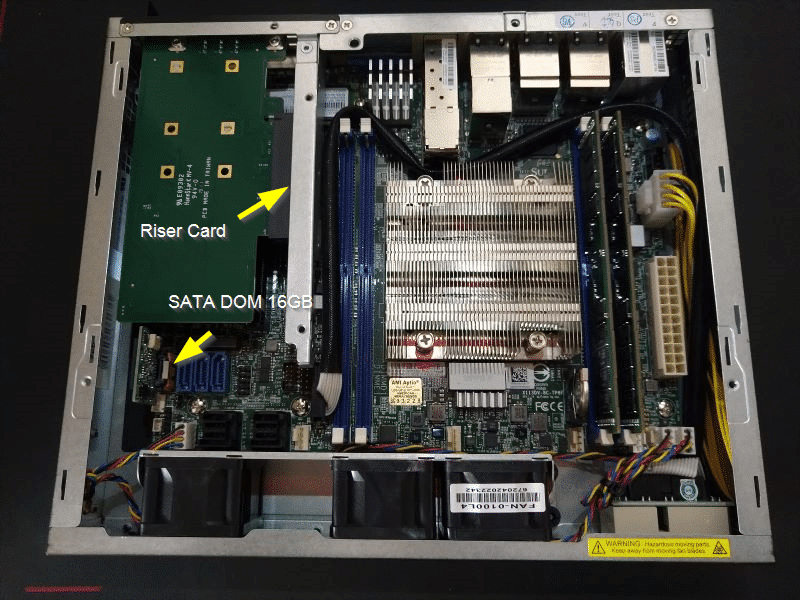

Unter der Gehäuseabdeckung befindet sich eine Abschirmung aus Metall (im Bild bereits entfernt). Die Rückseite des Servers mit den Netzwerk-Adaptern ist am oberen Bildrand zu sehen. In der Mitte sieht man den Kühlkörper der CPU und beiderseits zwei Slots für Speichermodule. Im vorderen Teil sehen wir eine Reihe Lüfter, die sich im Ruhebetrieb als angenehm leise herausstellten. Subjektiv macht mein Netgear Switch mehr Lärm, als alle vier Hosts zusammen.

Links der Mitte ist die PCIe Riserkarte zu sehen. Das Mainboard verfügt nur über einen M.2 Steckplatz für eine Flashdisk. Daher war ein PCIe Hostbusadapter mit zwei weiteren M.2 Anschlüssen notwendig. Da dieser nicht senkrecht auf den PCIe Slot gesteckt werden kann, benötigt man eine Riserkarte. Damit kann der M.2 HBA im Gehäuse waagerecht verbaut werden. Wir sehen links oben die Unterseite der HBA Karte.

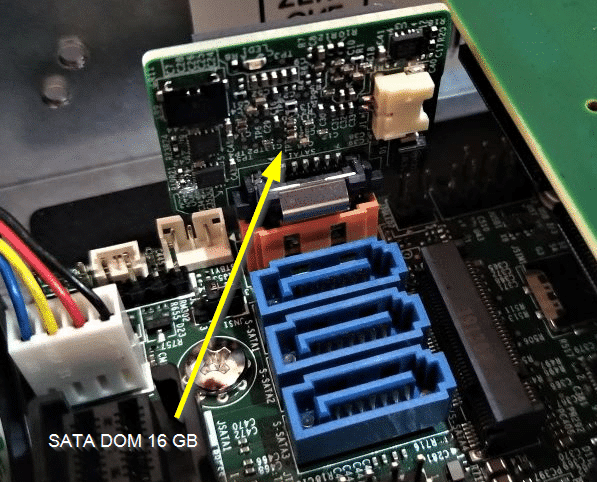

SATA DOM

Der ESXi benötigt ein eigenes Bootmedium. Supermicro bietet hier eine kleine 16 GB disk-on-module (DOM) an, die direkt auf den SATA Anschluss gesteckt wird.

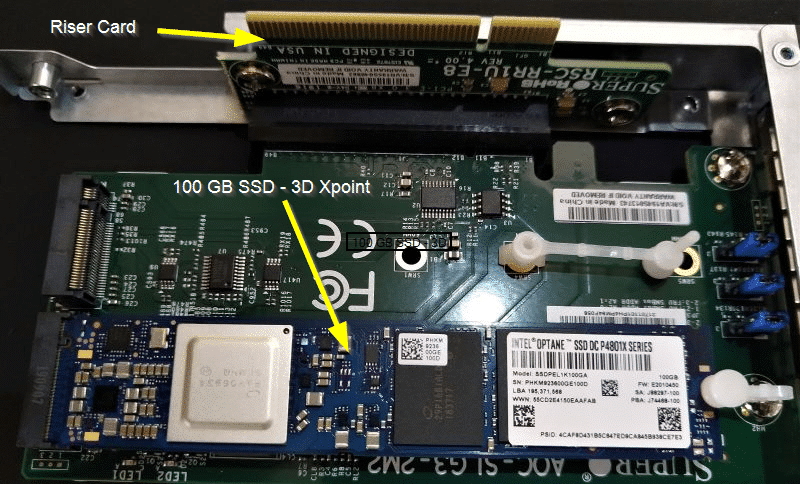

Riserkarte und HBA

Im nächsten Bild ist die ausgebaute Riserkarte mit dem HBA zu sehen. Einer der beiden M.2 Slots ist bereits mit der Intel Optane Karte (Cache) bestückt.

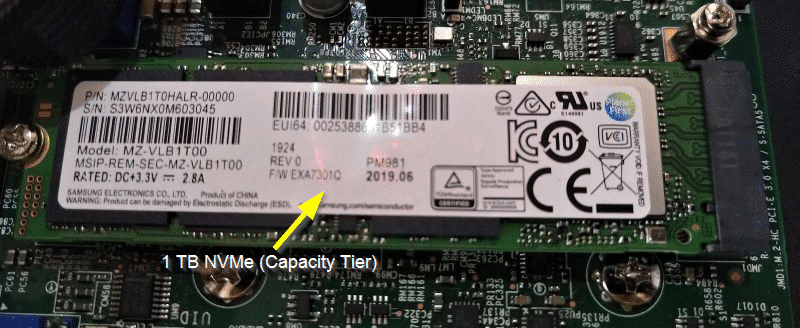

Im nächsten Bild sehen wir das Mainboard mit dem integrierten M.2 Slot und einer Samsung SSD als Capacity Tier.

An dieser Stelle ist natürlich die Frage erlaubt, warum nicht die Samsung SSD auf die Dualport Karte gesteckt wurde und die Optane auf das Mainboard. Auf dem HBA dürfen keine unterschiedlichen Karten verbaut werden und wir dürfen nur ein Cache Device pro Diskgroup haben. Die Nachrüstung einer zweiten Samsung SSD im Capacity-Tier ist damit versperrt. Die Antwort ist simpel: Die Optane Karte passt nicht auf das Mainboard und so musste ich die Kröte schlucken und den zweiten HBA Slot ungenutzt lassen.

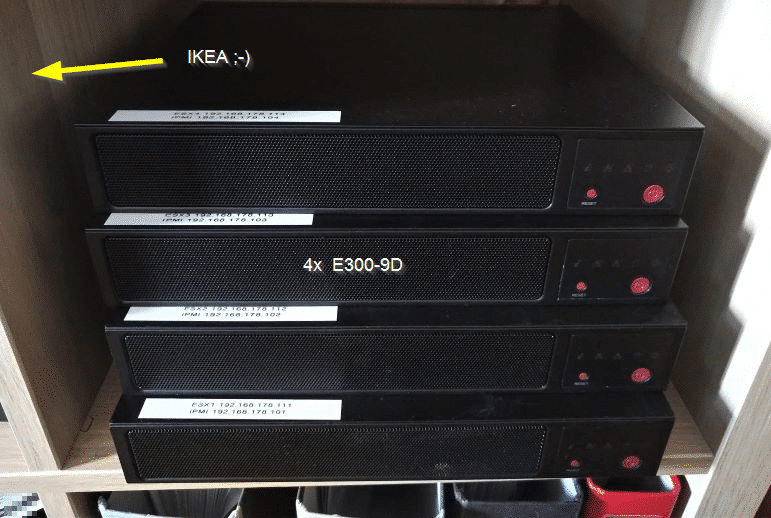

Micro Rack – designed in Sweden

Alle vier Hosts passen gut in ein Low-Budget IKEA Regal aus gepresster Kamelkacke. Kabel ein- oder umstecken ist ein wenig fummelig, aber es geht.

Weiter zu Teil 3 – Homelab Upgrade von IKEA zu 19 Zoll

Anstatt hier klug zu scheissen und copy/paste aus englischen blogs zu kopieren/übersetzen, würdest du lieber eine vernünftige step-by-step anleitung veröffentlichen – würde allen mehr bringen

Hallo unbekannter Besucher

Ich bin offen für jede Art der Anregung und Kritik und freue mich über Besucherfeedback.

Der Vorwurf, geistiges Eigentum anderer zu stehlen, ist für einen Blogger schwerwiegend.

Dieser Cluster steht in meinem Lab. Text und Bilder wurden von mir erstellt. Falls ich fremde Quellen zitiere, dann grundsätzlich mit Link und unter Angabe des Urhebers.

Das einzige Copy/Paste erfolgt zwischen der englischen und deutschen Version meines eigenen Beitrages auf diesem Blog. Bitte nenne konkret die vermeintliche Quelle, die hier angeblich kopiert wurde. Das würde mich doch sehr überraschen. 🙂

Was meinst Du mit einer Schritt-für-Schritt Anleitung? Wie ich den Schraubenzieher angesetzt habe um das Gehäuse zu öffnen? Dies ist keine Anleitung und war auch nicht als solche gedacht. Es werden vielmehr die Komponenten des verwendeten Serverknotens vorgestellt.

Übrigens: Glückwunsch zum ersten negativen Kommentar seit Gründung des Blogs 2010!

Also ich fand es gut. Da ich gerade nach DIY HCI Ansätzen suche, ist dein Beitrag eine gute Anregung sich Supermicro dafür anzusehen.

Freut mich. Danke 🙂

Hallo Michael,

was ist mit Teil 3 geworden?

Ich bin gerade an einem ähnlichen Cluster dran und merke, dass die Samsung PM981 nicht auf der vSAN HCL stehen.

Ergab das für dich irgendwelche Probleme?

Hallo Nico.

Die PM981 war ursprünlich mal auf der HCL, ist dann aber irgendwie rausgefallen. Probleme macht das keine – zumindest nicht im Homelab.

Ein Argument gegen die Samsung NVMe ist das grauenvolle Firmware Management. Booten in eine Firmware-Upgrade Umgebung? Fehlanzeige!

Unter Windows kann man es vielleicht versuchen (Samsung Magician). Keine Ahnung ob das funktioniert. Hatte bisher keine Lust, meine Flashmedien aus dem ESXi Host zu schrauben und in meinen PC zu klemmen.

Den Link zu Teil 3 habe ich aktualisiert – Danke für die Erinnerung. 🙂

Das Lab läuft gut – sogar unter 7U3 (von VMware zurückgezogen). Die U3 löste mir ein paar Probleme, weswegen ich dabei bleibe. Ist ja keine Produktivumgebung. 😉